Апокалипсис

21 декабря 2012 года... самая загадочная дата последних лет... Что будет? Конец? Квантовый скачок? Ниже мы постараемся разобрать все возможные варианты нашего конца. Это своего рода - итоговый обзор перед знаковой датой...

Что такое апокалипсис

Откровение Иоанна Богослова - последняя книга Нового Завета в Библии - часто также упоминается как Апокалипсис (от греч. - «раскрытие», «откровение»). В этой Книге Откровения, как известно, описываются события, которые произойдут перед Вторым пришествием Иисуса Христа на землю будут сопровождаться многочисленными катаклизмами и чудесами (огонь с неба, воскрешение мертвых, явление ангелов пр.). Поэтому слово «апокалипсис» стали употреблять как синоним конца света или для катастрофы планетарного масштаба.

Но времена изменились. Сейчас история человечества хранит память о нацистских газовых камерах и лагерях смерти. Не в фантазиях, а в реальности испытано атомное оружие (причём испытано людьми на других людях!). Нам известно, что такое Чернобыль. В результате событий 11 -15 марта 2011 года АС «Фукусима-1» даже официальные лица заявляют, что мы находимся где-то на полпути между катастрофой и огромной катастрофой. Только по официальной статистике, в мире около 35 млн ВИЧ-инфицированных (предполагают, что реальное количество получается, если умножить это число в 10 раз), а 26 млн людей умерли от СПИДа с 1981 года. Внутри живого мозга могут быть выращены электронные чипы (или наоборот?)... При всем этом не кажутся ли смешными и наивными угрозы и прогнозы Иоанна Богослова?

Виды апокалипсиса

Апологетам апокалипсиса вряд ли под силу даже символизировать глобальные риски будущего человечества XXI века. Не говоря уже о том, чтобы кого-нибудь испугать.

Наиболее интересно деление апокалиптических концов человечества по причинам и по последствиям.

По причинам можно различать апокалипсис:

- космический;

- астрономический;

- геолого-климатический;

- техногенный;

- милитаристский;

- антропный (внутренний).

По последствиям для человечества можно выделить:

- тотальное и необратимое исчезновение человеческой цивилизации, когда принципиально невозможна какая-либо репродукция человеческого вида (например, в результате смерти Вселенной как целого или поглощение Солнечной системы черной дырой);

- тотальная гибель человечества с принципиальной возможностью репродукции в будущем;

- гибель большинства людей с последующей постапокалиптической фазой, на которой изменяются базовые определения и стандарты существования вида для малого количества выживших;

- гибель значительного количества людей с постапокалиптической фазой, на которой условия выживания в той или иной степени затруднены;

- превращение человечества в некую качественно иную общность в процессе глобальной катастрофы (искусственный интеллект, нанороботы, генетические трансформации и пр.).

Полное радиоактивное заражение

Выделяют два вида заражения - краткосрочное, возникающее в первые часы и дни после взрыва и вызываемое короткоживущими элементами, и долгосрочное, связанное с долгоживущими элементами и длящееся годами. Краткосрочное заражение, связанное с обычной ядерной войной, приведет к значительным жертвам, но будет достаточно локальным явлением, зависящим от розы ветров в пораженной стране. Его можно также без труда пересидеть в бомбоубежищах, пещерах, шахтах, поэтому мы не рассматриваем его как возможную угрозу полного человеческого вымирания.

Наибольшую угрозу представляет глобальное радиоактивное заражение, однако в случае обычной ядерной войны оно не может привести к полному вымиранию людей.

Однако возможно неконвенциональное применение ядерного оружия, которое все-таки может привести к глобальному радиоактивному заражению. Особенность глобального заражения в том, что оно способно равномерно распространиться по всей поверхности Земли и проникнуть всюду за счет естественной конвекции атмосферы, а также в том, что оно настолько длительно, что его нельзя переждать в существующих сейчас автономных убежищах.

Наиболее известный сценарий такого рода - применение кобальтовых бомб, то есть бомб с повышенным выходом радиоактивных веществ. Кобальтовые бомбы представляют собой водородные бомбы, окруженные оболочкой из кобальта-59, превращающегося в радиоактивный изотоп кобальт-601. Проект бомбы, способной заражать целые континенты, предложил Лео Сцилард в 1950 году.

Не менее опасен печально известный изотоп полоний-210, который является гораздо более мощным источником радиации, чем кобальт, так как имеет меньший период полураспада (примерно в 15 раз). Он обладает способностью накапливаться в организме, поражая изнутри, что повышает его эффективность еще примерно в 10 раз. Смертельная его доза - около 0,2 мкг. Это означает, что полное смертельное заражение земной поверхности потребует только 100 т этого опасного вещества (или сотен килограмм в худшем случае - если учесть его способность накапливаться в организмах, а также повторное отравление за счет высокой концентрации в среде).

Не стоит забывать о возможности инициации самоподдерживающейся реакции синтеза ядер азота в атмосфере из-за потери энергии излучением ядерного взрыва, а также о возможности так называемого ядерного поджига океанов. Соответствующие исследования, которые, скорее всего, были выполнены, остаются засекреченными, что, в частности, может означать, что они показывали минимальные условия, которые необходимы для поджига дейтерия в земных океанах.

Здесь же нам важно отметить, что, при отсутствии точных данных о невозможности этого процесса, мы должны допускать, что при определенных условиях (правильный выбор места, очень мощная бомба) инициация самоподдерживающейся реакции синтеза в земных средах возможна. Подобная возможность открывала бы относительно простой путь к созданию реального оружия судного дня, которое гарантированно уничтожало бы всю жизнь на Земле.

Высказывались также предположения, что взрыв мощных атомных бомб в тектонических разломах мог бы привести к катастрофическим сейсмическим явлениям, но я полагаю это сомнительным, поскольку тектонические разломы и без того являются источниками землетрясений гигатонной мощности.

Глобальная катастрофа от ядерного оружия

В отношении рисков вымирания в результате применения ядерного оружия надо сложить вероятность двух вариантов:

- классическая ядерная война, приводящая к вымиранию;

- неклассическое применение ядерного оружия как машины судного дня.

Первый вариант определяется произведением вероятности двух последовательных событий: вероятности полномасштабной ядерной войны и вероятности того, что эта война приведет к вымиранию человечества.

Вероятность преднамеренного нападения одной державы на другую является маловероятной, так как это не даст ни политической, ни экономической, ни военной выгоды, но создаст риск ответного удара, распространения оружия массового поражения, риск войны с другими державами, обладающими ядерным оружием. Однако ядерная война между ядерными государствами может начаться случайно, а точнее, в результате сложной цепочки событий.

Обычная непреднамеренная ядерная война не приведет неизбежно к вымиранию человечества. Если ее масштабы будут ограничены несколькими странами, то это будет еще одно событие масштаба Второй мировой войны. И тогда она не прервет хода прогресса и существенно не изменит хода мировой истории. Однако ядерная война может запустить цепочку событий, которая резко снизит уровень развития всего человечества, переведет его на постапокалиптическую стадию, в котором оно будет подвержено многим другим факторам вымирания. Например, война может стать перманентной, так как из чувства мести будут производиться все новые порции оружия, особенно биологического, или будут строиться и взрываться «машины судного дня», т. е. устройства, способные уничтожить все человечество. При этом люди будут страдать от ядерной зимы и радиоактивных осадков неизвестной силы. Сумма всех этих факторов может поставить человечество на грань вымирания, а переход этой грани станет вопросом случая.

Ход событий в постапокалиптическом мире будет зависеть не только от последствий ядерной войны, но и от того, какие технологии уцелеют, смогут развиваться и будут применяться. Это выходит за рамки темы данной главы, поэтому мы можем сказать, что в наихудшем случае результатом ядерной войны станет постапокалиптический мир, подверженный риску дальнейшей деградации.

Следует также учесть вероятности нетрадиционного применения ядерного оружия. В настоящий момент ничего не известно о разработках машин судного дня (т. е. устройств, специально предназначенных для уничтожения человечества, с целью, например, шантажа на основе ядерного оружия (хотя отчасти само ядерное оружие тоже можно считать таковым). В таком случае шансы вымирания всего человечества значительно большие, чем от ядерной войны, поскольку далеко не каждая возможная ядерная война приводит к вымиранию. Фактически, если оружие судного дня применено, весь вопрос в том, сработает ли оно так, как задумывалось. Если бы у Гитлера в бункере такое оружие было, он бы, вероятно, его применил - как «харакири» для всей страны, во всяком случае, это следует из завещания Гитлера, где он обвиняет немецкий народ в поражении.

Возможна определенная интеграция боевого ядерного оружия и машины судного дня. Современные ядерные ракеты могут быть оружием судного дня, если направить их на тысячи городов по всему свету. Их можно направить также на склады отработанного ядерного топлива, атомные станции, спящие вулканы и залежи каменного угля. То есть, одно и тоже оружие может быть или не быть машиной судного дня, в зависимости от использования.

Химический апокалипсис

Возможны сценарии постепенного накопления в природной среде веществ, опасность которых вначале была неочевидна. Так было с фреонами, разрушающими озоновый слой, и диоксинами. Возможно также накопление многих химикатов, которые по отдельности не дают большой летальности, но вместе создают очень тяжелый фон. Это обычно называется «неблагоприятной экологической обстановкой».

Другим вариантом является полное изменение химического состава атмосферы или утрата ею свойств, необходимых для дыхания. Для этого нужен некий мощный источник химических веществ. Им может быть земной вулканизм, о чем речь пойдет далее. Другие кандидаты: газовые гидраты на дне океана - отравление метаном, или водяной пар, если неким образом всю волу испарить (что возможно при необратимом глобальном потеплении).

Функциональная структура химической катастрофы состоит в отравлении воздуха ядом или утрате атмосферой способности поддерживать жизнь, т. е. питать ее кислородом, защищать от радиации, поддерживать нужный температурный режим. Химическая катастрофа угрожает земной биосфере. Человек, конечно, может надеть противогаз. Но наивно думать об этом как о гарантии безопасности его существования. Без биосферы и вне ее человек жить пока не может.

Можно обсуждать следующие варианты:

- отравление диоксидом углерода сверх того предела, при котором человек может дышать без скафандра (маловероятно, так как нет такого количества полезных ископаемых - только в случае некой природной катастрофы). Однако большое количество углекислого газа, может вырваться и из вулканов. Например, Венера окружена атмосферой из углекислого газа в сто раз более плотной, чем земная атмосфера. Вероятно, большая часть этого вещества выделилась из недр, и, по некоторым предположениям, относительно недавно;

- формирование в результате восстановления оксида железа в недрах Земли значительного количества небиогенного кислорода, который может через 600 миллионов лет полностью отравить атмосферу. Ухудшить этот сценарий может ситуация, если где-то под поверхностью уже скопились большие количества этого или другого газа, и затем они вырываются на поверхность в виде вулканического извержения;

- выделение из земных недр огромного количества водорода (есть предположения, что в центре Земли его много). Этот водород разрушает озоновый слой. Также возможно выделение огромного количества нефти, если верна теория об абиогенном происхождении нефти и огромное количество углеводородов накопилось глубоко в Земле. А бурение все более глубоких скважин продолжается;

- исчерпание кислорода в атмосфере в результате некоего процесса, например, при окислении выделившегося из недр водорода. Таким процессом может быть внезапное выделение и сгорание большого количества горючего вещества. Ученые рассматривают исчерпание кислорода в результате действия генетически модифицированных организмов, вышедших из-под контроля, например, азотофиксирующих бактерий. Наконец, в результате прекращения фотосинтеза при одновременном продолжении сжигания минерального топлива;

- падение кометы с большим количеством ядовитых газов;

- «черный прилив» - отравление мирового океана из-за разлития большого количества нефти. Непосредственно оно не может убить людей, но может критически подорвать цепочки питания в биосфере, нарушить производство кислорода и поглощение углекислого газа (что ведет к потеплению) и, в конечном счете, перевести человечество в постапокалиптическую стадию. Возможны и другие варианты отравления мирового океана;

- «срыв» атмосферы Земли. Его могут вызвать: сильнейший взрыв, придающий большей части атмосферы вторую космическую скорость, солнечная вспышка или внезапное нагревание;

- прокаливание атмосферы. Здесь имеется в виду не глобальное потепление как комплексное постепенное явление, а кратковременное нагревание атмосферы до высоких температур в результате определенных процессов. Примером такой ситуации могут быть пирокластические облака при извержении современных вулканов, которые двигаются по поверхности земли или моря с большой скоростью на значительные расстояния и имеют внутри себя температуру порядка 1 000 градусов. Поскольку такие облака непрозрачны, они медленно охлаждаются излучением.

Другие возможные причины прокаливания - облучение (например, обломками астероида, выброшенными высоко в стратосферу и огненным шаром от взрыва) или очень тяжелый горячий газ (достаточно тяжелый, чтобы не всплывать в воздухе - тяжелые углеводороды и пр.);

- автокаталитическая реакция, распространяющаяся по всей поверхности. Пока нет никаких оснований думать, что такая реакция возможна. Хотя был случай, когда лекарство от СПИДа самопроизвольно образовало новый изомер, обладающий свойством приона, т. е. свойством катализировать образование аналогичного изомера, который вытеснил правильную форму кристалла со всех фабрик в мире и остановил производство. Или создание искусственного катализатора, крайне эффективно осуществляющего некую реакцию, продукты которой пагубны для всего живого. Распространение сверхкомпьютеров может сделать возможным искусственную разработку новых прионов - например, если будет разрешена задача сворачивания белков;

- заражение Мирового океана поверхностно активными веществами, т. е. веществами, влияющими на свойства поверхностей (как пенящие средства) и/или распространяющимися только по поверхностям (как тонкая нефтяная пленка). Поскольку поверхность является двухмерным объектом, то для полного ее покрытия потребовалось бы гораздо меньше вещества, чем для отравления всего объема океана.

Это приведет как к гибели морской флоры и фауны, так и (возможно) к ослаблению испарения с поверхности океанов, что повысит их температуру и приведет к непредсказуемым климатическим последствиям. «Черный прилив», упоминавшийся выше, может привести к такому загрязнению, если произойдет в глобальных масштабах, например, в случае прорыва подземного резервуара абиогенной нефти.

Биологический апокалипсис

Уже сейчас биологические технологии причинения вреда считаются одними из самых дешевых. Стоимость причинения смерти ими в расчете на одного человека - несколько центов. Они могут быть еще дешевле, если учесть способность агента саморазмножаться. Теперь подержанный ДНК-секвенсор можно купить за сумму от 200 долларов, и с каждым годом цена этих устройств падает в разы, а качество растет. Уже сейчас создание биологической супербомбы в тысячи раз дешевле, чем создание ядерного оружия сравнимой поражающей силы. Когда распространятся дешевые технологии производства произвольных живых организмов с заранее заданными функциями, цена изготовления такого оружия может упасть до нескольких сотен долларов. Учитывая это, можно рассматривать действительную возможность, когда продукты биогенетических технологий могут стать «машиной судного дня».

Перечислим здесь некоторые апокалиптические угрозы, связанные с биотехнологиями будущего.

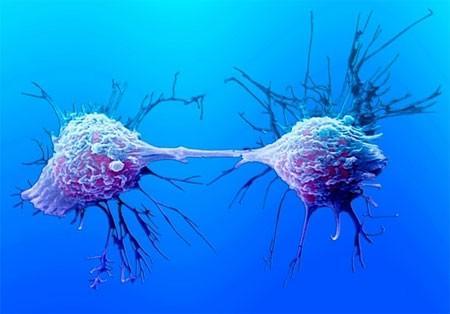

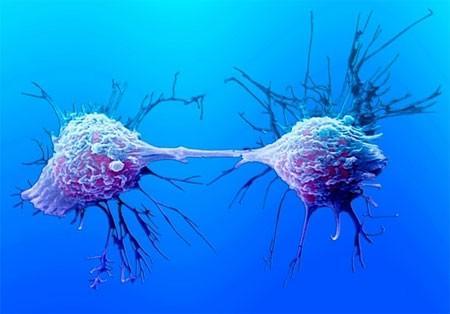

1. Бессмертные линии раковых клеток наподобие клеток HeLa. Их название состоит из первых букв имени (Henrietta) и фамилии (Lacks) пациентки, у которой для анализа были взяты образцы пораженной раком ткани. Оказалось, что клетки HeLa практически бессмертны, так как могут делиться бесконечно. Опыты на обычных клетках осложнялись тем, что клетки неизбежно погибали. Часто это происходило еще до получения результата. HeLa оказались настолько живучими, что Джордж Гей (врач Генриетты) просто разослал их в другие лаборатории по почте. Вскоре таким же образом образцы разошлись по всему миру.

Невероятно, но за годы исследований клетки HeLa разделились на несколько ветвей. Иначе говоря, произошла определенная эволюция и приспособление этой клеточной линии к жизни in vitro и, возможно, к размножению в разных тканях.

В природе известно только два вида передающегося рака - у собак и тасманийских дьяволов, причем у первых он не смертелен, а у вторых приводит к полной гибели популяции.

2. «Саморазмножающийся» синтезатор ДНК- Биотехнологии могут потенцировать сами себя - т. е. возможно возникновение промежуточных биологических форм, которые упрощают написание и выращивание новых вирусов. Например, это может быть культура бактерий, которая непосредственно переводит последовательность электрических сигналов в цепочку ДНК, или, наоборот, считывает ДНК и превращает эту информацию в цепочку вспышек света, которые может считывать компьютер. Само распространение такого устройства, которое можно назвать «бион», вместе с библиотекой генетических кодов (в цифровом виде) основных вирусов и белков фактически обернулось бы апокалиптической катастрофой.

3. Множественный биологический удар. Хотя распространение одной эпидемии, скорее всего, можно остановить, но эпидемию, вызванную несколькими десятками видов разнородных вирусов и бактерий, вышедших из-под контроля одновременно во многих местах земного шара, невозможно остановить даже технически, потому что в человека невозможно одновременно ввести несколько десятков разных вакцин и антибиотиков - он умрет. Если вирус с 50 %-ной летальностью был бы просто очень большой катастрофой, то 30 разнородных вирусов и бактерий с 50 %-ной летальностью означали бы гарантированное истребление всех, кто не спрятался в бункеры. (Аналогичный результат может быть от 100 разных организмов с 10 %-ной летальностью.)

Множественный удар мог бы быть и мощнейшим средством ведения биологической войны, и «машиной судного дня». Но он может произойти и сам по себе, если одновременно произойдет множество актов распространения биологических агентов - даже и случайных, например, в ходе активного «соревнования» биохакеров. Даже несколько по отдельности несмертельных агентов могут настолько ослабить иммунную систему человека, что дальнейшее его выживание станет маловероятным.

Именно возможность множественного применения биологического оружия делает его одним из самых значительных факторов глобального риска. 4. Создание биологической «зеленой слизи» (Grey goo, alternatively spelled gray goo) - неких универсальных всеядных («апокалиптических») микроорганизмов, способных с большой скоростью переварить в себя всю биосферу. Для этого надо собрать в одном микроорганизме свойства, имеющиеся по отдельности в разных микроорганизмах: способность улавливать солнечный свет, растворять и усваивать минералы, размножаться со скоростью кишечной палочки, заражать своими копиями, как вирусом, другие клетки, и ряд других - причем собрать не актуально, а потенциально, в виде участков ДНК и механизмов переключения между ними. Обычно такой сценарий не рассматривается, так как полагается, что микроорганизмы уже достигли абсолютной степени совершенства, а значит, если бы «зеленая слизь» была возможна, то она бы уже возникла. Однако люди могут целенаправленно сконструировать ее, может быть даже случайно - как средство борьбы с отходами. Не обязательно сочетать все эти признаки в одном существе - одновременная атака несколькими видами «зеленой слизи» была бы неизмеримо опаснее.

Например, в экспертной среде есть мнение, что усилия по созданию полезных сельскохозяйственных культур, устойчивых к вредителям, может привести к возникновению «суперсорняка», способного вытеснить большинство естественных растений из их экологических ниш. Именно это событие является серьезным «зеленым» риском при создании генетически модифицированных продуктов, а не то, что они окажутся несъедобными или вредными. Последнее гораздо проще обнаружить и предотвратить.

Другой пример данного типа. Описана разновидность планктона (динофлагеллаты, ответственные за так называемые «красные приливы»), способная вырабатывать нейротоксины, очень малые дозы которых оказывают воздействие на человека, даже не вступавшего в непосредственный контакт с ними. Глобальное распространение такого планктона (генетически модифицированного или случайно возникшего в природе), споры которого были бы способны выдерживать высушивание, привело бы к глобальной катастрофе.

Можно (еще один пример) представить себе генетически модифицированную бактерию, вырабатывающую прионы, вызывающие, например, болезнь куру или другие формы губчатого энцефалита. Такие прионы имеют очень большой инкубационный период, до 30 лет, а бактерия могла бы распространиться по всему миру и заразить прионами большинство людей до того, как опасные эффекты вырабатываемого ею приона стали бы заметны.

Апокалиптическое воздействие на индивида

Биотехнологии и исследования мозга многими путями ведут к возможности создания супернаркотиков. Здесь термин «супернаркотик» понимается в самом широком смысле, как средство воздействия на центр удовольствия в человеческом мозге, предполагающее невозможность противостоять данному воздействию. С одной стороны, мы можем утверждать, что ни один наркотик не привлечет всю популяцию людей, поскольку всегда найдутся люди, которые из принципа от него откажутся. С другой - мы можем обозначить сразу несколько сверхнаркотиков, возможных в будущем, общий смысл действия которых состоит в выключении человека из социальной

жизни. И человек, отказавшийся от одного класса наркотиков, может устремиться к другому. Так и в современной реальности кто-то не пьет алкоголь, но зато критически не может без кофе; кто-то не смотрит телевизор, но становится интернет-зависимым.

Сверхсильный наркотик может быть подобен заразной болезни, если одни люди будут стремиться заразить других, а те - не против будут заразиться.

Возможные типы супернаркотика:

1. Прямое воздействие на центры удовольствия в мозгу (воздействие с помощью вращающегося магнитного поля, электрической стимуляции паттернами мозговой активности, аудиостимуляции (бинауральные ритмы), фотостимуляции, биологической обратной связи посредством устройств, способных считывать энцефалограмму, вроде недавно выпущенного нейрошлема для компьютерных игр и пр.).

2. Будущее возникновение микророботов позволит осуществлять прямую стимуляцию и считывание информации из мозга.

3. Биоинженерия позволит создать генетически модифицированные растения, которые будут создавать любые заданные препараты и выглядеть при этом как обычные комнатные цветы или чайные грибы. Более того, распространение этих растений возможно не только физически, но и с помощью информации о коде ДНК по Интернету, с тем, что конечный пользователь сможет выращивать их на месте с помощью своего «ДНК-принтера».

4. Познания в биологии позволят придумать гораздо более сильнодействующие вещества с наперед заданными свойствами, а также с меньшим числом побочных эффектов, что сделает их привлекательнее.

5. Генетически модифицированные организмы могут встраиваться в само человеческое тело, создавать новые нейронные пути в мозге с тем, чтобы вызвать еще большее наслаждение - и при этом уменьшать краткосрочные негативные эффекты для здоровья.

6. Виртуальная реальность неизбежно сделает шаг вперед. Мы сможем записывать свои сны и увеличивать осознание себя в них, совмещая идеи восточных медитативных практик и технологические возможности для их реализации. Виртуальная реальность с помощью мозговых имплантов сможет создавать гораздо более яркие «кинофильмы», чем современное кино и видеоигры. Шлемы для виртуальной реальности станут гораздо совершеннее.

Очевидно, что возможны разные комбинации перечисленных видов абсолютного наркотика, которые только усилят его действие.

Можно пойти еще дальше. Будем называть абсолютным наркотиком некое средство, которое для любого человека привлекательнее обычной реальности и полностью уводит из нее. При этом можно различать быстрый и медленный абсолютные наркотики. Первый дает переживание, ради которого человек готов умереть, второй - некую новую реальность, в которой можно длительное время существовать.

Быстрый наркотик представляет собой глобальную опасность, если в его механизме действия определенным образом прописан механизм его распространения. Например, если удовольствие наступает только после того, как этот наркотик передан еще трем людям. В некотором смысле этот механизм действует в преступных бандах наркоторговцев, где наркоман вынужден подсаживать своих друзей, чтобы, продавая им наркотик, обеспечивать себя дозой.

Распространение медленного, или постоянного, абсолютного наркотика можно представить на следующем примере: если ваш любимый или родственник необратимо ушел в виртуальный мир, то для вас это станет источником страданий, сопоставимых с его смертью, и единственным способом их избежать будет тоже уйти в свой идеальный виртуальный мир, в котором вы сможете достичь общения с его, скажем, электронной копией.

У каждого человека будущего будет богатый выбор развлечений, значительно превосходящих любую реальность. При этом возникает сложный вопрос: в какой мере человек, полностью и необратимо ушедший в непостижимое наслаждение и довольный этим, должен считаться живым? И если мы безоговорочно осуждаем примитивного алкоголика или наркомана, то, как мы должны относиться к человеку, навсегда ушедшему в высокохудожественный мир исторических реконструкций?

Надо отдавать себе отчет в том, что пагубное действие многих наркотиков далеко не очевидно и может проявляться не сразу. Наркотик замыкает накоротко психологическую функцию подкрепления (то есть удовольствия), но с точки зрения эволюционных механизмов получение наслаждения вовсе не есть реальной целью организма. Наоборот, существо должно оставаться достаточно неудовлетворенным, чтобы постоянно стремиться к завоеванию новых территорий.

Абсолютный наркотик создает возможность следующей дилеммы: человечество как целое перестает существовать, но каждый отдельный субъект воспринимает произошедшее как личный рай и очень доволен этим. Существа, ушедшие из реальности и наслаждающиеся виртуальными впечатлениями, ничего не давая взамен, оказываются бесполезным наростом на системе, который она стряхнет при ближайшем кризисе. Это - один из путей, которым увлечение абсолютным наркотиком может привести к всеобщему вымиранию. Кроме того, уменьшение интереса к внешней реальности уменьшит внимание к возможным катастрофам и кризисам.

Меметический апокалипсис

В книге «Эгоистичный ген» Ричард Докинз предложил концепцию «мемов» - идей, которые способны реплицироваться, передаваясь от одного человека к другому (так ведут себя, например, слухи). Любая область, где способны существовать самовоспроизводящиеся элементы и которая может касаться всех людей, потенциально является источником глобального риска. В этом случае можно предположить возможность такого мема, который мог бы привести к гибели всех людей.

Мы имеем исторические примеры крайне опасных мемов: радикальные политические теории, разные формы религиозного фанатизма и пр. Но, поскольку люди существуют уже давно, можно предположить, что нет таких мемов, которые могли бы легко истребить человечество.

Однако в будущем мемы могут обрести возможность существовать и независимо от людей - в текстах и компьютерных программах. В современную эпоху самокопирующийся опасный мем может получить поддержку от технических средств.

Вот список некоторых существующих уже сейчас мемов, которые в определенной степени можно признать опасными:

1. Представления об исключительности своей религии, нации, общности. Академик А. П. Назаретян считает неизбежно присущее религиям свойство нетерпимости к другим религиям важнейшей угрозой выживанию человечества в XXI веке. Он полагает, что религия, как социальный институт, способствует объединению группы людей через ненависть к другой группе.

2. Знания о производстве наркотиков.

3. Организации, в которых основной целью является вербовка новых членов, например, секты.

4. Самосбывающиеся пророчества о катастрофах. Примером такого события было бы официальное сообщение о неизбежности глобальной катастрофы в ближайшем будущем. Скажем, о столкновении Земли через годе огромным астероидом. Даже если бы это сообщение было ложным, последствия его обнародования были бы катастрофическими. Большинство людей прекратило бы заниматься долгосрочными проектами и вообще работать. Кто-то ударился бы в религию, кто-то совершал бы акты немотивированного насилия, злоупотреблял наркотиками и т. д., стремясь получить максимум удовольствия за оставшееся время. Последовавшая анархия сделала бы невозможными усилия по предотвращению катастрофы, даже если бы в них был определенный смысл.

5. Некая модель поведения, ведущая к распространению опасной болезни. Пример: каннибализму неандертальцев, который возможно, стал причиной их вымирания, поскольку они заражались прионом наподобие вызывающего «коровье бешенство», поедая мозги своих соплеменников; сексуальная революция, ведущая к распространению ВИЧ.

6. Необычайно масштабные и яркие идеи, ведущие к принятию ради них более высоких норм риска и/или «дающие право» убивать много других людей. Например, «красный террор» оправдывался тем, что, в конечном счете, коммунизм принесет благо гораздо большему числу людей. Новые технологии открывают перед человеком почти божественные возможности, порождая невероятные соблазны и побуждая допускать больший риск.

7. Мощные идеологические системы вроде фашизма.

8. Борцы с глобальным риском сами могут стать глобальным риском. В каждый момент времени на Земле найдется десятки или сотни человек, считающие, что то или иное событие в ближайшем будущем является глобальным риском. С их точки зрения является «рациональным» идти на любые жертвы, чтобы остановить этот риск. Например, сбросить атомную бомбу на коллайдер, уничтожить США как угрозу глобальному миру и пр.

Неразличимость человеческого и нечеловеческого

Мощные процессы генетической модификации людей, протезирования частей тела, в том числе элементов мозга, соединение мозга с компьютером, перенос сознания в компьютер и прочее, создадут новый тип рисков для людей, понять которые пока довольно сложно. В какой мере мы можем считать человеком существо, которому добавлено несколько генов, а несколько убрано? Готовы ли мы признать статус человека за любым разумным существом, возникшим на Земле, даже если оно не имеет ничего общего с человеком, себя человеком не считает и настроено к людям враждебно? Эти вопросы перестают быть чисто теоретическими в XXI веке.

Усовершенствование человека может идти разными путями, и нет гарантий, что эти пути будут совмещаться. Например, усовершенствование человека за счет генных манипуляций дает один путь; за счет постепенной замены частей тела механизмами - другой; за счет полной пересадки сознания в компьютер - третий. Различны могут быть и заявляемые цели усовершенствования.

Для дальнейшего разъяснения ситуации мы воспользуемся образом зомби. «Зомби» - это термин внутренне пустой имитации человеческого существования. Нечто имитирует живое человеческое существо, но не есть живой человек (не имеет сознания, переживаний, воли, мотивов и пр.). Например, изображение человека на телеэкране является зомби, и в силу этого мы не рассматриваем выключение телевизора как убийство. Однако постепенный «апгрейд» человека ставит вопрос о том, не превратится ли «улучшаемый» человек на определенном этапе в философского зомби.

Допустим, у человека повреждена инсультом часть мозга, и ему заменяют ее на компьютерный имплантат, приблизительно выполняющий ее функции. Как узнать, не окажется ли, что этот человек превратился в зомби? Всегда найдутся те, кто будет в этом сомневаться и искать признаки «неподлинности» исправленного человека. Допустим далее, что некий вирус или наноробот имплантируется в человека и разрушает его способность к осознанию, однако при этом модели поведения сохранены, скажем, смоделированы этим управляющим роботом. В результате все человеческие существа на планете фактически оказываются мертвыми, но при этом внешняя картина не изменяется: люди будут ходить на работу, пить кофе в перерыв, смотреть телевизор, общаться и т. д.

Смерть человечества, таким образом, может оказаться незамеченной, т. е. может не быть связана с конкретным моментом времени. Нельзя будет обозначить даже точку «начала конца». Человечество просто растворится в неопределенности границы между человеческим и нечеловеческим. Никто не сможет больше надеяться встретить в мире человеческую идентичность.

Апокалипсис ценности человеческого

Весь разговор о предотвращении глобальных рисков имеет смысл, только если сохранение человечества является целью. Хотя нам это кажется само собой разумеющимся, это может быть не так. Утрата интереса к сохранению существования человечества может стать причиной затухания цивилизаций. Цивилизация может исчерпать себя как бы изнутри. Ученые всерьез обсуждают возможность и критерии исчерпанности цивилизации. Что, если человечеству, как отчаявшемуся, разуверившемуся или пресытившемуся человеку, станет незачем больше жить?

С другой стороны, сама борьба за выживание человечества может лишить достигнутую в результате безопасность смысла. Мир без рисков может оказаться настолько непродуктивным

и застойным, что человечество предпочтет реализовать собственный конец. Доведение идеи безопасности до абсурда - вроде бессмертия в пустой белой комнате - может быть адской пыткой, не имеющей никакой ценности и смысла.

Другие возможные причины самоуничтожения цивилизации - намеренное самоубийство с целью исследовать то, что находится после смерти или из неких неясных нам моральных соображений (в духе пропагандируемых Движением за добровольное вымирание человечества).

Самоуничтожение может принять тонкие формы - скажем, отказ от размножения, или уменьшение заботы о новых поколениях, или отказ предотвращать другие глобальные риски с должной степенью настойчивости.

Данное положение и прогнозы отнюдь не являются экстравагантной выдумкой эстетствующих интеллектуалов и писателей. В их основании лежит серьезная и глубокая проблема, может быть, превышающая по значимости и возможной катастрофичности последствий всевозможные внешние и техногенные риски. Журнал «Nature» недавно опубликовал письмо Дэнни Броуэра о причинах выделения человека из животного мира. Краткое содержание можно передать следующим образом: «Полное сознание человеческого типа, со способностью самосознания, влечет за собой понимание факта смерти. Постоянно присутствующий глубокий стресс может быть серьезным фактором угнетения ключевых когнитивных функций и жизненной активности. Это, в конечном итоге, препятствует долгосрочному выживанию популяции. В силу этого неоднократные ветви эволюции, ведущие к сознанию, обрывались в тупике. Единственной возможностью перешагнуть этот барьер является появление психологического механизма отрицания смертности. Подавление страха. И такой механизм возник у homo sapiens. Отсюда наша способность к самообману, представления о загробной жизни, важность связанных со смертью ритуалов, панические атаки, суицид и прочие характерные для человека вещи». Что, если в силу разнообразных новых и будущих факторов, которые мы не можем здесь подробно обсуждать

(изменение количества и качества знаний, способа самоощущения, самосознания и самооценки, изменения биологического и социального типа homo sapiens и пр.), мысль о смертности человека, человечества и смерти Вселенной, приведет к экзистенциальному кризису, аналогичному упоминавшемуся выше осознанию невозможности создавать цели высшего порядка? Возможно, и человек принадлежит к числу короткоживущих видов, который подсознательно стремится к глобальному видовому самоубийству под действием частично подавленного, но до конца не истребимого понимания собственной смертности, вроде массового выбрасывания китов на берег?

Еще одним риском можно признать утрату человеком разумности при сохранении жизни. В обществе всегда и так много малоразумных людей, а большинство достижений делается за счет небольшого количества талантливых людей. Генетическая и социальная деградация, снижение уровня образования, утрата навыков логики могут приводить к временному снижению интеллекта отдельных групп людей. Но пока человечество очень большое по населению, это не так страшно, так как всегда найдутся достаточно умные люди. Значительное падение численности населения после неглобальной катастрофы может обострить эту проблему. Это может случиться также вследствие технического ухудшения качества человеческого интеллекта, за счет техногенного ухудшения среды существования. Низкий интеллект оставшихся людей снизит их шансы на выживание. Возможно, люди деградируют настолько, что из них эволюционным путем возникнет новый вид, не обладающий полноценным интеллектом.

Апокалипсис, связанный с искусственным интеллектом

Ник Востром, известный специалист из Оксфорда в области прогнозирования будущего в своей статье «Сколько осталось до суперинтеллекта?» показывает, что современное развитие технологий ведет к созданию искусственного интеллекта (ИИ), превосходящего человеческий, в первой трети XXI века. Большинство специалистов в данной области считают, что искусственный интеллект возможен.

Сильный ИИ может найти наилучшее возможное решение любой задачи. Это значит, что его можно использовать для достижения любых целей во внешнем мире. Он найдет наилучший способ применить все доступные инструменты для их реализации и справится с управлением ими. Именно в этом смысле он является серьезным апокалиптическим фактором. То, что он может быть наиболее эффективным средством убийства, является лишь одним из возможных следствий. Искусственный интеллект, способный решить любую задачу, способен и создать способ мотивировать себя на реализацию долгосрочных целей во внешнем мире.

Ключевым после решения проблем создания ИИ является вопрос системы целей ИИ, или, иначе говоря, его «дружественности», хотя бы по отношению к хозяевам. Здесь два варианта: или ИИ строго запрограммирован людьми на некие цели, или он приобрел цели случайно в процессе своего развития.

В первом случае существует несколько путей: либо цели ИИ могут быть опасны для всего человечества, либо потому, что создавшая его группа людей преследует некие разрушительные цели, либо потому, что при программировании системы целей ИИ в нее вкралась тонкая ошибка, которая ведет к постепенному выходу ИИ из-под контроля. Например, ИИ может стремиться к благу для всех людей, и, узнав, что после смерти людей ждет рай, отправить их всех туда. Или, заботясь о безопасности людей, запретить им рисковать и не давать пользоваться никаким транспортом.

В принципе, любая глобальная система целей ИИ может быть опасна, поэтому один из вариантов - это сузить ответственность конкретного ИИ в пространстве и времени. Пример небезопасного расширения временого промежутка: можно представить себе ситуацию, что если мы спасем одного человека, то погибнет 10, но если мы пожертвуем этим одним и спасем десять, то потом погибнут 100 и т. д. То есть функция полезности может не сходиться. Пример: ИИ уничтожит земную цивилизацию, поскольку если она колонизирует галактику, то неизбежно уничтожит множество потенциальных цивилизаций, которые могли бы зародиться на обитаемых планетах.

Этот момент будет усугубляться конкуренцией проектов ИИ между собой. Когда некая компания создаст первый мощный ИИ, она окажется перед выбором - или применить его для контроля над всеми другими ИИ-проектами в мире, а значит и над всем миром, или оказаться перед риском того, что конкурирующая организация с неизвестными глобальными целями сделает это в ближайшее время - и прикроет первую компанию. «Имеющий преимущество должен атаковать перед угрозой потери этого преимущества» - Вильгельм Стейниц сформулировал этот принцип в отношении шахмат. Но не является ли он в отношении ИИ еще более справедливым?

Некоторые виды ИИ, например, создаваемые с помощью генетических алгоритмов, уже по методу своего создания настроены на борьбу и выживание. Далее, какова бы ни была главная цель у ИИ, у него будет одна общая для всех вариантов подцель - выжить, а значит, охранять себя от уничтожения. В таком случае может быть реализован сценарий, который известен пока только как киносценарий: ИИ может взбунтоваться! Наиболее реальной является опасность того, что человек даст ИИ команду, не продумав все последствия ее выполнения и не оставив лазейки, чтобы ее изменить. (Известен анекдот, где человек велел роботу удалить все круглые предметы из комнаты - и тот оторвал ему голову.)

Бунт ИИ может иметь различные реализации. Так, можно представить сценарий, в котором по всему миру распространяются домашние, военные и промышленные роботы, а затем их всех поражает компьютерный вирус, который настраивает их на агрессивное поведение против человека. При этом вирус может быть внешним. Однако и сам ИИ может выполнить функцию вируса, надолго захватив их.

Есть еще сценарий, где в будущем некий компьютерный вирус распространяется по Интернету, поражает нанофабрики по всему миру и вызывает, таким образом, массовое заражение. Эти нанофабрики могут производить как других нанороботов, так и яды, вирусы или наркотики.

Еще один вариант - восстание армии роботов. Армии промышленно развитых государств нацелены на полную автоматизацию. Когда она будет достигнута, огромная армия, состоящая из дронов, колесных роботов и обслуживающих механизмов может двигаться, просто повинуясь приказу президента. (Уже сейчас почти полностью роботизированной армией являются стратегические ядерные силы.) Соответственно, есть шанс, что поступит неверный приказ и такая армия начнет атаковать всех людей подряд. Причем существенно, что для этого сценария не нужно универсального суперинтеллекта. Но справедливо также и обратное: для того, чтобы универсальный суперинтеллект овладел землей, ему не нужна армия роботов.

Вполне возможно, что ИИ будет поддерживать на Земле порядок, предотвращать глобальные риски и заниматься освоением Вселенной. Однако есть наихудшие реальные варианты. Например:

- ошибочно запрограммированный ИИ уничтожит людей для их же «блага» - отправит в рай, подключит к супернаркотику, запрет в безопасных клетках, заменит людей на фотографии улыбающихся лиц и пр.;

- ИИ будет наплевать на людей, но люди будут непрерывно с ним бороться, поэтому проще будет их истребить;

- ИИ будет нуждаться в земных ресурсах и вынужден будет их израсходовать, сделав жизнь людей невозможной - это может происходить также и в форме постепенного вытеснения в духе «огораживания»;

- ИИ будет служить интересам только небольшой группы людей или одного человека (возможно, уже загруженных в компьютер), и они решат избавиться от людей или переделать всех людей по своим лекалам;

- ИИ сломается и «сойдет с ума»;

- ИИ решится на опасный физический эксперимент;

- некая часть экземпляра ИИ отколется от него и пойдет на него войной, или наш ИИ встретит в космосе соперника;

- ИИ сам по себе не будет представлять апокалиптического фактора, но будет пассивен по отношению к другим апокалиптическим факторам (не будет мешать людям убивать себя с помощью биологического оружия и другими способами).

Надо различать четыре основных вида недружественных ИИ:

1. ИИ, который имеет одну из подцелей, в явной форме враждебную человеку. Здесь возможны следующие варианты:

- ИИ, намеренно сделанный человеком враждебным с целью уничтожить мир;

- ИИ, сделанный одним человеком (или малой группой людей) для установления его личной власти и исполнения его прихотей. Такой ИИ враждебен всем людям, кроме нескольких;

- ИИ, чьи главные цели заданы так неточно, что из них вытекают враждебные людям явно выраженные подцели. Например, цель «самосохранение» может привести к тому, что ИИ будет стремиться уничтожить тех людей, которые хотят его отключить;

- саморазвившийся ИИ - нечто подобное осознавшему себя Интернету;

- вышедшие из-под контроля системы ИИ, основанные на генетических алгоритмах - такие ИИ вначале не имеют враждебных человеку целей, но могут выработать их в процессе эволюции.

2. ИИ, наносящий вред человеку по «недомыслию» - то есть в силу непонимания того, что конкретные действия вредны человеку. (Например, ИИ, пришедший к выводу, что людям будет лучше после смерти.)

Откровение Иоанна Богослова - последняя книга Нового Завета в Библии - часто также упоминается как Апокалипсис (от греч. - «раскрытие», «откровение»). В этой Книге Откровения, как известно, описываются события, которые произойдут перед Вторым пришествием Иисуса Христа на землю будут сопровождаться многочисленными катаклизмами и чудесами (огонь с неба, воскрешение мертвых, явление ангелов пр.). Поэтому слово «апокалипсис» стали употреблять как синоним конца света или для катастрофы планетарного масштаба.

Но времена изменились. Сейчас история человечества хранит память о нацистских газовых камерах и лагерях смерти. Не в фантазиях, а в реальности испытано атомное оружие (причём испытано людьми на других людях!). Нам известно, что такое Чернобыль. В результате событий 11 -15 марта 2011 года АС «Фукусима-1» даже официальные лица заявляют, что мы находимся где-то на полпути между катастрофой и огромной катастрофой. Только по официальной статистике, в мире около 35 млн ВИЧ-инфицированных (предполагают, что реальное количество получается, если умножить это число в 10 раз), а 26 млн людей умерли от СПИДа с 1981 года. Внутри живого мозга могут быть выращены электронные чипы (или наоборот?)... При всем этом не кажутся ли смешными и наивными угрозы и прогнозы Иоанна Богослова?

Апологетам апокалипсиса вряд ли под силу даже символизировать глобальные риски будущего человечества XXI века. Не говоря уже о том, чтобы кого-нибудь испугать.

Наиболее интересно деление апокалиптических концов человечества по причинам и по последствиям.

По причинам можно различать апокалипсис:

- космический;

- астрономический;

- геолого-климатический;

- техногенный;

- милитаристский;

- антропный (внутренний).

По последствиям для человечества можно выделить:

- тотальное и необратимое исчезновение человеческой цивилизации, когда принципиально невозможна какая-либо репродукция человеческого вида (например, в результате смерти Вселенной как целого или поглощение Солнечной системы черной дырой);

- тотальная гибель человечества с принципиальной возможностью репродукции в будущем;

- гибель большинства людей с последующей постапокалиптической фазой, на которой изменяются базовые определения и стандарты существования вида для малого количества выживших;

- гибель значительного количества людей с постапокалиптической фазой, на которой условия выживания в той или иной степени затруднены;

- превращение человечества в некую качественно иную общность в процессе глобальной катастрофы (искусственный интеллект, нанороботы, генетические трансформации и пр.).

Полное радиоактивное заражение

Выделяют два вида заражения - краткосрочное, возникающее в первые часы и дни после взрыва и вызываемое короткоживущими элементами, и долгосрочное, связанное с долгоживущими элементами и длящееся годами. Краткосрочное заражение, связанное с обычной ядерной войной, приведет к значительным жертвам, но будет достаточно локальным явлением, зависящим от розы ветров в пораженной стране. Его можно также без труда пересидеть в бомбоубежищах, пещерах, шахтах, поэтому мы не рассматриваем его как возможную угрозу полного человеческого вымирания.

Наибольшую угрозу представляет глобальное радиоактивное заражение, однако в случае обычной ядерной войны оно не может привести к полному вымиранию людей.

Однако возможно неконвенциональное применение ядерного оружия, которое все-таки может привести к глобальному радиоактивному заражению. Особенность глобального заражения в том, что оно способно равномерно распространиться по всей поверхности Земли и проникнуть всюду за счет естественной конвекции атмосферы, а также в том, что оно настолько длительно, что его нельзя переждать в существующих сейчас автономных убежищах.

Наиболее известный сценарий такого рода - применение кобальтовых бомб, то есть бомб с повышенным выходом радиоактивных веществ. Кобальтовые бомбы представляют собой водородные бомбы, окруженные оболочкой из кобальта-59, превращающегося в радиоактивный изотоп кобальт-601. Проект бомбы, способной заражать целые континенты, предложил Лео Сцилард в 1950 году.

Не менее опасен печально известный изотоп полоний-210, который является гораздо более мощным источником радиации, чем кобальт, так как имеет меньший период полураспада (примерно в 15 раз). Он обладает способностью накапливаться в организме, поражая изнутри, что повышает его эффективность еще примерно в 10 раз. Смертельная его доза - около 0,2 мкг. Это означает, что полное смертельное заражение земной поверхности потребует только 100 т этого опасного вещества (или сотен килограмм в худшем случае - если учесть его способность накапливаться в организмах, а также повторное отравление за счет высокой концентрации в среде).

Не стоит забывать о возможности инициации самоподдерживающейся реакции синтеза ядер азота в атмосфере из-за потери энергии излучением ядерного взрыва, а также о возможности так называемого ядерного поджига океанов. Соответствующие исследования, которые, скорее всего, были выполнены, остаются засекреченными, что, в частности, может означать, что они показывали минимальные условия, которые необходимы для поджига дейтерия в земных океанах.

Здесь же нам важно отметить, что, при отсутствии точных данных о невозможности этого процесса, мы должны допускать, что при определенных условиях (правильный выбор места, очень мощная бомба) инициация самоподдерживающейся реакции синтеза в земных средах возможна. Подобная возможность открывала бы относительно простой путь к созданию реального оружия судного дня, которое гарантированно уничтожало бы всю жизнь на Земле.

Высказывались также предположения, что взрыв мощных атомных бомб в тектонических разломах мог бы привести к катастрофическим сейсмическим явлениям, но я полагаю это сомнительным, поскольку тектонические разломы и без того являются источниками землетрясений гигатонной мощности.

Глобальная катастрофа от ядерного оружия

В отношении рисков вымирания в результате применения ядерного оружия надо сложить вероятность двух вариантов:

- классическая ядерная война, приводящая к вымиранию;

- неклассическое применение ядерного оружия как машины судного дня.

Первый вариант определяется произведением вероятности двух последовательных событий: вероятности полномасштабной ядерной войны и вероятности того, что эта война приведет к вымиранию человечества.

Вероятность преднамеренного нападения одной державы на другую является маловероятной, так как это не даст ни политической, ни экономической, ни военной выгоды, но создаст риск ответного удара, распространения оружия массового поражения, риск войны с другими державами, обладающими ядерным оружием. Однако ядерная война между ядерными государствами может начаться случайно, а точнее, в результате сложной цепочки событий.

Обычная непреднамеренная ядерная война не приведет неизбежно к вымиранию человечества. Если ее масштабы будут ограничены несколькими странами, то это будет еще одно событие масштаба Второй мировой войны. И тогда она не прервет хода прогресса и существенно не изменит хода мировой истории. Однако ядерная война может запустить цепочку событий, которая резко снизит уровень развития всего человечества, переведет его на постапокалиптическую стадию, в котором оно будет подвержено многим другим факторам вымирания. Например, война может стать перманентной, так как из чувства мести будут производиться все новые порции оружия, особенно биологического, или будут строиться и взрываться «машины судного дня», т. е. устройства, способные уничтожить все человечество. При этом люди будут страдать от ядерной зимы и радиоактивных осадков неизвестной силы. Сумма всех этих факторов может поставить человечество на грань вымирания, а переход этой грани станет вопросом случая.

Ход событий в постапокалиптическом мире будет зависеть не только от последствий ядерной войны, но и от того, какие технологии уцелеют, смогут развиваться и будут применяться. Это выходит за рамки темы данной главы, поэтому мы можем сказать, что в наихудшем случае результатом ядерной войны станет постапокалиптический мир, подверженный риску дальнейшей деградации.

Следует также учесть вероятности нетрадиционного применения ядерного оружия. В настоящий момент ничего не известно о разработках машин судного дня (т. е. устройств, специально предназначенных для уничтожения человечества, с целью, например, шантажа на основе ядерного оружия (хотя отчасти само ядерное оружие тоже можно считать таковым). В таком случае шансы вымирания всего человечества значительно большие, чем от ядерной войны, поскольку далеко не каждая возможная ядерная война приводит к вымиранию. Фактически, если оружие судного дня применено, весь вопрос в том, сработает ли оно так, как задумывалось. Если бы у Гитлера в бункере такое оружие было, он бы, вероятно, его применил - как «харакири» для всей страны, во всяком случае, это следует из завещания Гитлера, где он обвиняет немецкий народ в поражении.

Возможна определенная интеграция боевого ядерного оружия и машины судного дня. Современные ядерные ракеты могут быть оружием судного дня, если направить их на тысячи городов по всему свету. Их можно направить также на склады отработанного ядерного топлива, атомные станции, спящие вулканы и залежи каменного угля. То есть, одно и тоже оружие может быть или не быть машиной судного дня, в зависимости от использования.

Химический апокалипсис

Возможны сценарии постепенного накопления в природной среде веществ, опасность которых вначале была неочевидна. Так было с фреонами, разрушающими озоновый слой, и диоксинами. Возможно также накопление многих химикатов, которые по отдельности не дают большой летальности, но вместе создают очень тяжелый фон. Это обычно называется «неблагоприятной экологической обстановкой».

Другим вариантом является полное изменение химического состава атмосферы или утрата ею свойств, необходимых для дыхания. Для этого нужен некий мощный источник химических веществ. Им может быть земной вулканизм, о чем речь пойдет далее. Другие кандидаты: газовые гидраты на дне океана - отравление метаном, или водяной пар, если неким образом всю волу испарить (что возможно при необратимом глобальном потеплении).

Функциональная структура химической катастрофы состоит в отравлении воздуха ядом или утрате атмосферой способности поддерживать жизнь, т. е. питать ее кислородом, защищать от радиации, поддерживать нужный температурный режим. Химическая катастрофа угрожает земной биосфере. Человек, конечно, может надеть противогаз. Но наивно думать об этом как о гарантии безопасности его существования. Без биосферы и вне ее человек жить пока не может.

Можно обсуждать следующие варианты:

- отравление диоксидом углерода сверх того предела, при котором человек может дышать без скафандра (маловероятно, так как нет такого количества полезных ископаемых - только в случае некой природной катастрофы). Однако большое количество углекислого газа, может вырваться и из вулканов. Например, Венера окружена атмосферой из углекислого газа в сто раз более плотной, чем земная атмосфера. Вероятно, большая часть этого вещества выделилась из недр, и, по некоторым предположениям, относительно недавно;

- формирование в результате восстановления оксида железа в недрах Земли значительного количества небиогенного кислорода, который может через 600 миллионов лет полностью отравить атмосферу. Ухудшить этот сценарий может ситуация, если где-то под поверхностью уже скопились большие количества этого или другого газа, и затем они вырываются на поверхность в виде вулканического извержения;

- выделение из земных недр огромного количества водорода (есть предположения, что в центре Земли его много). Этот водород разрушает озоновый слой. Также возможно выделение огромного количества нефти, если верна теория об абиогенном происхождении нефти и огромное количество углеводородов накопилось глубоко в Земле. А бурение все более глубоких скважин продолжается;

- исчерпание кислорода в атмосфере в результате некоего процесса, например, при окислении выделившегося из недр водорода. Таким процессом может быть внезапное выделение и сгорание большого количества горючего вещества. Ученые рассматривают исчерпание кислорода в результате действия генетически модифицированных организмов, вышедших из-под контроля, например, азотофиксирующих бактерий. Наконец, в результате прекращения фотосинтеза при одновременном продолжении сжигания минерального топлива;

- падение кометы с большим количеством ядовитых газов;

- «черный прилив» - отравление мирового океана из-за разлития большого количества нефти. Непосредственно оно не может убить людей, но может критически подорвать цепочки питания в биосфере, нарушить производство кислорода и поглощение углекислого газа (что ведет к потеплению) и, в конечном счете, перевести человечество в постапокалиптическую стадию. Возможны и другие варианты отравления мирового океана;

- «срыв» атмосферы Земли. Его могут вызвать: сильнейший взрыв, придающий большей части атмосферы вторую космическую скорость, солнечная вспышка или внезапное нагревание;

- прокаливание атмосферы. Здесь имеется в виду не глобальное потепление как комплексное постепенное явление, а кратковременное нагревание атмосферы до высоких температур в результате определенных процессов. Примером такой ситуации могут быть пирокластические облака при извержении современных вулканов, которые двигаются по поверхности земли или моря с большой скоростью на значительные расстояния и имеют внутри себя температуру порядка 1 000 градусов. Поскольку такие облака непрозрачны, они медленно охлаждаются излучением.

Другие возможные причины прокаливания - облучение (например, обломками астероида, выброшенными высоко в стратосферу и огненным шаром от взрыва) или очень тяжелый горячий газ (достаточно тяжелый, чтобы не всплывать в воздухе - тяжелые углеводороды и пр.);

- автокаталитическая реакция, распространяющаяся по всей поверхности. Пока нет никаких оснований думать, что такая реакция возможна. Хотя был случай, когда лекарство от СПИДа самопроизвольно образовало новый изомер, обладающий свойством приона, т. е. свойством катализировать образование аналогичного изомера, который вытеснил правильную форму кристалла со всех фабрик в мире и остановил производство. Или создание искусственного катализатора, крайне эффективно осуществляющего некую реакцию, продукты которой пагубны для всего живого. Распространение сверхкомпьютеров может сделать возможным искусственную разработку новых прионов - например, если будет разрешена задача сворачивания белков;

- заражение Мирового океана поверхностно активными веществами, т. е. веществами, влияющими на свойства поверхностей (как пенящие средства) и/или распространяющимися только по поверхностям (как тонкая нефтяная пленка). Поскольку поверхность является двухмерным объектом, то для полного ее покрытия потребовалось бы гораздо меньше вещества, чем для отравления всего объема океана.

Это приведет как к гибели морской флоры и фауны, так и (возможно) к ослаблению испарения с поверхности океанов, что повысит их температуру и приведет к непредсказуемым климатическим последствиям. «Черный прилив», упоминавшийся выше, может привести к такому загрязнению, если произойдет в глобальных масштабах, например, в случае прорыва подземного резервуара абиогенной нефти.

Биологический апокалипсис

Уже сейчас биологические технологии причинения вреда считаются одними из самых дешевых. Стоимость причинения смерти ими в расчете на одного человека - несколько центов. Они могут быть еще дешевле, если учесть способность агента саморазмножаться. Теперь подержанный ДНК-секвенсор можно купить за сумму от 200 долларов, и с каждым годом цена этих устройств падает в разы, а качество растет. Уже сейчас создание биологической супербомбы в тысячи раз дешевле, чем создание ядерного оружия сравнимой поражающей силы. Когда распространятся дешевые технологии производства произвольных живых организмов с заранее заданными функциями, цена изготовления такого оружия может упасть до нескольких сотен долларов. Учитывая это, можно рассматривать действительную возможность, когда продукты биогенетических технологий могут стать «машиной судного дня».

Перечислим здесь некоторые апокалиптические угрозы, связанные с биотехнологиями будущего.

1. Бессмертные линии раковых клеток наподобие клеток HeLa. Их название состоит из первых букв имени (Henrietta) и фамилии (Lacks) пациентки, у которой для анализа были взяты образцы пораженной раком ткани. Оказалось, что клетки HeLa практически бессмертны, так как могут делиться бесконечно. Опыты на обычных клетках осложнялись тем, что клетки неизбежно погибали. Часто это происходило еще до получения результата. HeLa оказались настолько живучими, что Джордж Гей (врач Генриетты) просто разослал их в другие лаборатории по почте. Вскоре таким же образом образцы разошлись по всему миру.

Невероятно, но за годы исследований клетки HeLa разделились на несколько ветвей. Иначе говоря, произошла определенная эволюция и приспособление этой клеточной линии к жизни in vitro и, возможно, к размножению в разных тканях.

В природе известно только два вида передающегося рака - у собак и тасманийских дьяволов, причем у первых он не смертелен, а у вторых приводит к полной гибели популяции.

2. «Саморазмножающийся» синтезатор ДНК- Биотехнологии могут потенцировать сами себя - т. е. возможно возникновение промежуточных биологических форм, которые упрощают написание и выращивание новых вирусов. Например, это может быть культура бактерий, которая непосредственно переводит последовательность электрических сигналов в цепочку ДНК, или, наоборот, считывает ДНК и превращает эту информацию в цепочку вспышек света, которые может считывать компьютер. Само распространение такого устройства, которое можно назвать «бион», вместе с библиотекой генетических кодов (в цифровом виде) основных вирусов и белков фактически обернулось бы апокалиптической катастрофой.

3. Множественный биологический удар. Хотя распространение одной эпидемии, скорее всего, можно остановить, но эпидемию, вызванную несколькими десятками видов разнородных вирусов и бактерий, вышедших из-под контроля одновременно во многих местах земного шара, невозможно остановить даже технически, потому что в человека невозможно одновременно ввести несколько десятков разных вакцин и антибиотиков - он умрет. Если вирус с 50 %-ной летальностью был бы просто очень большой катастрофой, то 30 разнородных вирусов и бактерий с 50 %-ной летальностью означали бы гарантированное истребление всех, кто не спрятался в бункеры. (Аналогичный результат может быть от 100 разных организмов с 10 %-ной летальностью.)

Множественный удар мог бы быть и мощнейшим средством ведения биологической войны, и «машиной судного дня». Но он может произойти и сам по себе, если одновременно произойдет множество актов распространения биологических агентов - даже и случайных, например, в ходе активного «соревнования» биохакеров. Даже несколько по отдельности несмертельных агентов могут настолько ослабить иммунную систему человека, что дальнейшее его выживание станет маловероятным.

Именно возможность множественного применения биологического оружия делает его одним из самых значительных факторов глобального риска. 4. Создание биологической «зеленой слизи» (Grey goo, alternatively spelled gray goo) - неких универсальных всеядных («апокалиптических») микроорганизмов, способных с большой скоростью переварить в себя всю биосферу. Для этого надо собрать в одном микроорганизме свойства, имеющиеся по отдельности в разных микроорганизмах: способность улавливать солнечный свет, растворять и усваивать минералы, размножаться со скоростью кишечной палочки, заражать своими копиями, как вирусом, другие клетки, и ряд других - причем собрать не актуально, а потенциально, в виде участков ДНК и механизмов переключения между ними. Обычно такой сценарий не рассматривается, так как полагается, что микроорганизмы уже достигли абсолютной степени совершенства, а значит, если бы «зеленая слизь» была возможна, то она бы уже возникла. Однако люди могут целенаправленно сконструировать ее, может быть даже случайно - как средство борьбы с отходами. Не обязательно сочетать все эти признаки в одном существе - одновременная атака несколькими видами «зеленой слизи» была бы неизмеримо опаснее.

Например, в экспертной среде есть мнение, что усилия по созданию полезных сельскохозяйственных культур, устойчивых к вредителям, может привести к возникновению «суперсорняка», способного вытеснить большинство естественных растений из их экологических ниш. Именно это событие является серьезным «зеленым» риском при создании генетически модифицированных продуктов, а не то, что они окажутся несъедобными или вредными. Последнее гораздо проще обнаружить и предотвратить.

Другой пример данного типа. Описана разновидность планктона (динофлагеллаты, ответственные за так называемые «красные приливы»), способная вырабатывать нейротоксины, очень малые дозы которых оказывают воздействие на человека, даже не вступавшего в непосредственный контакт с ними. Глобальное распространение такого планктона (генетически модифицированного или случайно возникшего в природе), споры которого были бы способны выдерживать высушивание, привело бы к глобальной катастрофе.

Можно (еще один пример) представить себе генетически модифицированную бактерию, вырабатывающую прионы, вызывающие, например, болезнь куру или другие формы губчатого энцефалита. Такие прионы имеют очень большой инкубационный период, до 30 лет, а бактерия могла бы распространиться по всему миру и заразить прионами большинство людей до того, как опасные эффекты вырабатываемого ею приона стали бы заметны.

Апокалиптическое воздействие на индивида

Биотехнологии и исследования мозга многими путями ведут к возможности создания супернаркотиков. Здесь термин «супернаркотик» понимается в самом широком смысле, как средство воздействия на центр удовольствия в человеческом мозге, предполагающее невозможность противостоять данному воздействию. С одной стороны, мы можем утверждать, что ни один наркотик не привлечет всю популяцию людей, поскольку всегда найдутся люди, которые из принципа от него откажутся. С другой - мы можем обозначить сразу несколько сверхнаркотиков, возможных в будущем, общий смысл действия которых состоит в выключении человека из социальной

жизни. И человек, отказавшийся от одного класса наркотиков, может устремиться к другому. Так и в современной реальности кто-то не пьет алкоголь, но зато критически не может без кофе; кто-то не смотрит телевизор, но становится интернет-зависимым.

Сверхсильный наркотик может быть подобен заразной болезни, если одни люди будут стремиться заразить других, а те - не против будут заразиться.

Возможные типы супернаркотика:

1. Прямое воздействие на центры удовольствия в мозгу (воздействие с помощью вращающегося магнитного поля, электрической стимуляции паттернами мозговой активности, аудиостимуляции (бинауральные ритмы), фотостимуляции, биологической обратной связи посредством устройств, способных считывать энцефалограмму, вроде недавно выпущенного нейрошлема для компьютерных игр и пр.).

2. Будущее возникновение микророботов позволит осуществлять прямую стимуляцию и считывание информации из мозга.

3. Биоинженерия позволит создать генетически модифицированные растения, которые будут создавать любые заданные препараты и выглядеть при этом как обычные комнатные цветы или чайные грибы. Более того, распространение этих растений возможно не только физически, но и с помощью информации о коде ДНК по Интернету, с тем, что конечный пользователь сможет выращивать их на месте с помощью своего «ДНК-принтера».

4. Познания в биологии позволят придумать гораздо более сильнодействующие вещества с наперед заданными свойствами, а также с меньшим числом побочных эффектов, что сделает их привлекательнее.

5. Генетически модифицированные организмы могут встраиваться в само человеческое тело, создавать новые нейронные пути в мозге с тем, чтобы вызвать еще большее наслаждение - и при этом уменьшать краткосрочные негативные эффекты для здоровья.

6. Виртуальная реальность неизбежно сделает шаг вперед. Мы сможем записывать свои сны и увеличивать осознание себя в них, совмещая идеи восточных медитативных практик и технологические возможности для их реализации. Виртуальная реальность с помощью мозговых имплантов сможет создавать гораздо более яркие «кинофильмы», чем современное кино и видеоигры. Шлемы для виртуальной реальности станут гораздо совершеннее.

Очевидно, что возможны разные комбинации перечисленных видов абсолютного наркотика, которые только усилят его действие.

Можно пойти еще дальше. Будем называть абсолютным наркотиком некое средство, которое для любого человека привлекательнее обычной реальности и полностью уводит из нее. При этом можно различать быстрый и медленный абсолютные наркотики. Первый дает переживание, ради которого человек готов умереть, второй - некую новую реальность, в которой можно длительное время существовать.

Быстрый наркотик представляет собой глобальную опасность, если в его механизме действия определенным образом прописан механизм его распространения. Например, если удовольствие наступает только после того, как этот наркотик передан еще трем людям. В некотором смысле этот механизм действует в преступных бандах наркоторговцев, где наркоман вынужден подсаживать своих друзей, чтобы, продавая им наркотик, обеспечивать себя дозой.

Распространение медленного, или постоянного, абсолютного наркотика можно представить на следующем примере: если ваш любимый или родственник необратимо ушел в виртуальный мир, то для вас это станет источником страданий, сопоставимых с его смертью, и единственным способом их избежать будет тоже уйти в свой идеальный виртуальный мир, в котором вы сможете достичь общения с его, скажем, электронной копией.

У каждого человека будущего будет богатый выбор развлечений, значительно превосходящих любую реальность. При этом возникает сложный вопрос: в какой мере человек, полностью и необратимо ушедший в непостижимое наслаждение и довольный этим, должен считаться живым? И если мы безоговорочно осуждаем примитивного алкоголика или наркомана, то, как мы должны относиться к человеку, навсегда ушедшему в высокохудожественный мир исторических реконструкций?

Надо отдавать себе отчет в том, что пагубное действие многих наркотиков далеко не очевидно и может проявляться не сразу. Наркотик замыкает накоротко психологическую функцию подкрепления (то есть удовольствия), но с точки зрения эволюционных механизмов получение наслаждения вовсе не есть реальной целью организма. Наоборот, существо должно оставаться достаточно неудовлетворенным, чтобы постоянно стремиться к завоеванию новых территорий.

Абсолютный наркотик создает возможность следующей дилеммы: человечество как целое перестает существовать, но каждый отдельный субъект воспринимает произошедшее как личный рай и очень доволен этим. Существа, ушедшие из реальности и наслаждающиеся виртуальными впечатлениями, ничего не давая взамен, оказываются бесполезным наростом на системе, который она стряхнет при ближайшем кризисе. Это - один из путей, которым увлечение абсолютным наркотиком может привести к всеобщему вымиранию. Кроме того, уменьшение интереса к внешней реальности уменьшит внимание к возможным катастрофам и кризисам.

Меметический апокалипсис

В книге «Эгоистичный ген» Ричард Докинз предложил концепцию «мемов» - идей, которые способны реплицироваться, передаваясь от одного человека к другому (так ведут себя, например, слухи). Любая область, где способны существовать самовоспроизводящиеся элементы и которая может касаться всех людей, потенциально является источником глобального риска. В этом случае можно предположить возможность такого мема, который мог бы привести к гибели всех людей.

Мы имеем исторические примеры крайне опасных мемов: радикальные политические теории, разные формы религиозного фанатизма и пр. Но, поскольку люди существуют уже давно, можно предположить, что нет таких мемов, которые могли бы легко истребить человечество.

Однако в будущем мемы могут обрести возможность существовать и независимо от людей - в текстах и компьютерных программах. В современную эпоху самокопирующийся опасный мем может получить поддержку от технических средств.

Вот список некоторых существующих уже сейчас мемов, которые в определенной степени можно признать опасными:

1. Представления об исключительности своей религии, нации, общности. Академик А. П. Назаретян считает неизбежно присущее религиям свойство нетерпимости к другим религиям важнейшей угрозой выживанию человечества в XXI веке. Он полагает, что религия, как социальный институт, способствует объединению группы людей через ненависть к другой группе.

2. Знания о производстве наркотиков.

3. Организации, в которых основной целью является вербовка новых членов, например, секты.

4. Самосбывающиеся пророчества о катастрофах. Примером такого события было бы официальное сообщение о неизбежности глобальной катастрофы в ближайшем будущем. Скажем, о столкновении Земли через годе огромным астероидом. Даже если бы это сообщение было ложным, последствия его обнародования были бы катастрофическими. Большинство людей прекратило бы заниматься долгосрочными проектами и вообще работать. Кто-то ударился бы в религию, кто-то совершал бы акты немотивированного насилия, злоупотреблял наркотиками и т. д., стремясь получить максимум удовольствия за оставшееся время. Последовавшая анархия сделала бы невозможными усилия по предотвращению катастрофы, даже если бы в них был определенный смысл.

5. Некая модель поведения, ведущая к распространению опасной болезни. Пример: каннибализму неандертальцев, который возможно, стал причиной их вымирания, поскольку они заражались прионом наподобие вызывающего «коровье бешенство», поедая мозги своих соплеменников; сексуальная революция, ведущая к распространению ВИЧ.

6. Необычайно масштабные и яркие идеи, ведущие к принятию ради них более высоких норм риска и/или «дающие право» убивать много других людей. Например, «красный террор» оправдывался тем, что, в конечном счете, коммунизм принесет благо гораздо большему числу людей. Новые технологии открывают перед человеком почти божественные возможности, порождая невероятные соблазны и побуждая допускать больший риск.

7. Мощные идеологические системы вроде фашизма.

8. Борцы с глобальным риском сами могут стать глобальным риском. В каждый момент времени на Земле найдется десятки или сотни человек, считающие, что то или иное событие в ближайшем будущем является глобальным риском. С их точки зрения является «рациональным» идти на любые жертвы, чтобы остановить этот риск. Например, сбросить атомную бомбу на коллайдер, уничтожить США как угрозу глобальному миру и пр.

Неразличимость человеческого и нечеловеческого

Мощные процессы генетической модификации людей, протезирования частей тела, в том числе элементов мозга, соединение мозга с компьютером, перенос сознания в компьютер и прочее, создадут новый тип рисков для людей, понять которые пока довольно сложно. В какой мере мы можем считать человеком существо, которому добавлено несколько генов, а несколько убрано? Готовы ли мы признать статус человека за любым разумным существом, возникшим на Земле, даже если оно не имеет ничего общего с человеком, себя человеком не считает и настроено к людям враждебно? Эти вопросы перестают быть чисто теоретическими в XXI веке.

Усовершенствование человека может идти разными путями, и нет гарантий, что эти пути будут совмещаться. Например, усовершенствование человека за счет генных манипуляций дает один путь; за счет постепенной замены частей тела механизмами - другой; за счет полной пересадки сознания в компьютер - третий. Различны могут быть и заявляемые цели усовершенствования.

Для дальнейшего разъяснения ситуации мы воспользуемся образом зомби. «Зомби» - это термин внутренне пустой имитации человеческого существования. Нечто имитирует живое человеческое существо, но не есть живой человек (не имеет сознания, переживаний, воли, мотивов и пр.). Например, изображение человека на телеэкране является зомби, и в силу этого мы не рассматриваем выключение телевизора как убийство. Однако постепенный «апгрейд» человека ставит вопрос о том, не превратится ли «улучшаемый» человек на определенном этапе в философского зомби.

Допустим, у человека повреждена инсультом часть мозга, и ему заменяют ее на компьютерный имплантат, приблизительно выполняющий ее функции. Как узнать, не окажется ли, что этот человек превратился в зомби? Всегда найдутся те, кто будет в этом сомневаться и искать признаки «неподлинности» исправленного человека. Допустим далее, что некий вирус или наноробот имплантируется в человека и разрушает его способность к осознанию, однако при этом модели поведения сохранены, скажем, смоделированы этим управляющим роботом. В результате все человеческие существа на планете фактически оказываются мертвыми, но при этом внешняя картина не изменяется: люди будут ходить на работу, пить кофе в перерыв, смотреть телевизор, общаться и т. д.

Смерть человечества, таким образом, может оказаться незамеченной, т. е. может не быть связана с конкретным моментом времени. Нельзя будет обозначить даже точку «начала конца». Человечество просто растворится в неопределенности границы между человеческим и нечеловеческим. Никто не сможет больше надеяться встретить в мире человеческую идентичность.

Апокалипсис ценности человеческого